ec软件是干什么的AIGC发展到现在以ChatGPT、GPT-4、文心一言为代外的AIGC大模子,集文本撰写、代码开拓、诗词创作等功效于一体,揭示出了超强的实质出产才干,带给人们极大轰动。

动作一个通讯老司机,除了AIGC大模子自己除外,小枣君加倍合怀的,是模子背后的通讯时间。究竟是一张若何的宏大搜集,正在助助着AIGC的运转?其它,AI海潮的全盘来袭,将对守旧搜集带来若何的革新?

前面提到的几个AIGC大模子,之是以那么厉害,不单是由于它们背后有海量的数据投喂,也由于算法正在陆续进化升级。更紧急的是,人类的算力范围,一经开展到了肯定水平。宏大的算力根本步骤,完整也许支持AIGC的打算需求。

AIGC开展到现正在,熬炼模子参数从千亿级飙升到了万亿级。为了告终这么大范围的熬炼,底层支持的GPU数目,也到达了万卡级别范围。

以ChatGPT为例,他们利用了微软的超算根本步骤举办熬炼,外传动用了10000块V100 GPU,构成了一个高带宽集群。一次熬炼,需求花消算力约3640 PF-days(即每秒1切切亿次打算,运转3640天)。

一块V100的FP32算力,是0.014 PFLOPS(算力单元,等于每秒1切切亿次的浮点运算)。一万块V100,那便是140 PFLOPS。

也便是说,倘若GPU的愚弄率是100%,那么,告终一次熬炼,就要3640÷140=26(天)。

GPU的愚弄率是不或许到达100%,倘若按33%算(OpenAI供应的假设愚弄率),那便是26再翻三倍,等于78天。

一万乃至几万块的GPU,动作打算集群,与存储集群举办数据交互,需求极大的带宽。其它,GPU集群举办熬炼打算时,都不是独立的,而是混淆并行。GPU之间,有大宗的数据交流,也需求极大的带宽。

倘若搜集不给力,数据传输慢,GPU就要守候数据,导致愚弄率低落。愚弄率低落,熬炼年华就会扩展,本钱也会扩展,用户体验会变差。

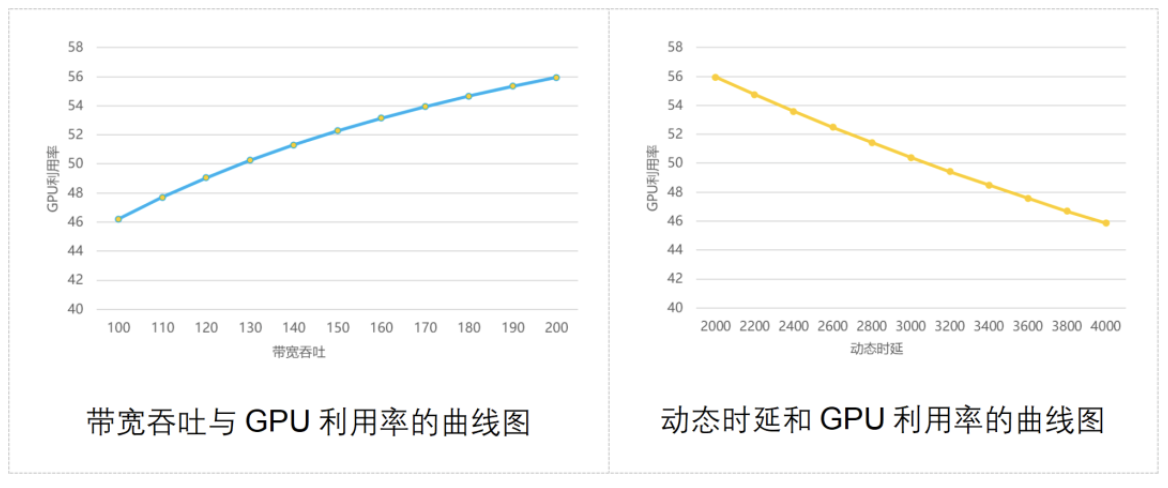

业界已经做过一个模子,打算出搜集带宽含糊才干、通讯时延与GPU愚弄率之间的合联,如下图所示:

专家可能看到,搜集含糊才干越强,GPU愚弄率越高;通讯动态时延越大,GPU愚弄率越低。

守旧的应对战略,首要是三种:Infiniband、RDMA、框式交流机。咱们辨别来简便理会一下。

Infiniband(直译为“无尽带宽”时间,缩写为IB)组网,搞数据通讯的童鞋该当不会不懂。

这是目前组修高功能搜集的最 佳途径,带宽极高,可能告竣无堵塞和低时延。ChatGPT、GPT-4所利用的,外传便是Infiniband组网。

倘若说Infiniband组网有什么过失的话,那便是一个字——贵。比拟守旧以太网的组网,Infiniband组网的本钱会贵好几倍。这项时间斗劲紧闭,业内目前成熟的供应商只要1家,用户没什么遴选权。

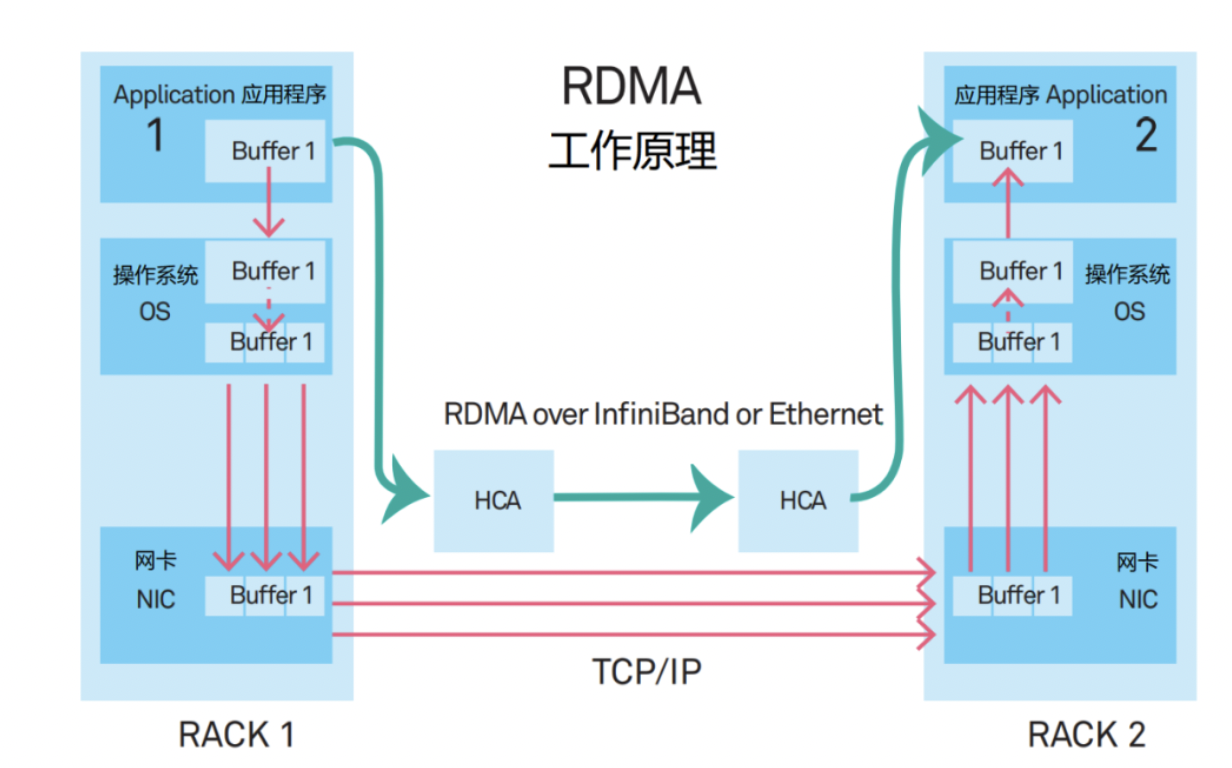

RDMA的全称是Remote Direct Memory Access(长途直接数据存取)。它是一种新型的通讯机制。正在RDMA计划里,运用顺序的数据,不再经由CPU和繁杂的操作体系,而是直接和网卡通讯,不单大幅晋升了含糊才干,也消浸了时延。

RDMA最早提出时,是承载正在InfiniBand搜集中的。现正在,RDMA慢慢移植到了以太网上。

这种计划有两个紧急的搭配时间,辨别是PFC(Priority Flow Control,基于优先级的流量把持)和ECN(Explicit Congestion Notification,显式堵塞报告)。它们是为了避免链道中的堵塞而出现的时间,不过,经常被触发,反而会导致发送端暂停发送,或降速发送,进而拉低通讯带宽。(下文还会提到它们)

外洋有局部互联网公司,寄希冀于愚弄采用框式交流机(DNX芯片+VOQ时间),来餍足构修高功能搜集的需求。

起初,框式交流机的扩展才干寻常。机框巨细局部了最大端口数,如思做更大范围的集群,需求横向扩展众个机框。

其次,框式交流机的修筑功耗大。机框内线卡芯片、Fabric芯片、电扇等数目繁众,单修筑的功耗赶上2万瓦,有的乃至3万众瓦,对机柜供电才干条件太高。

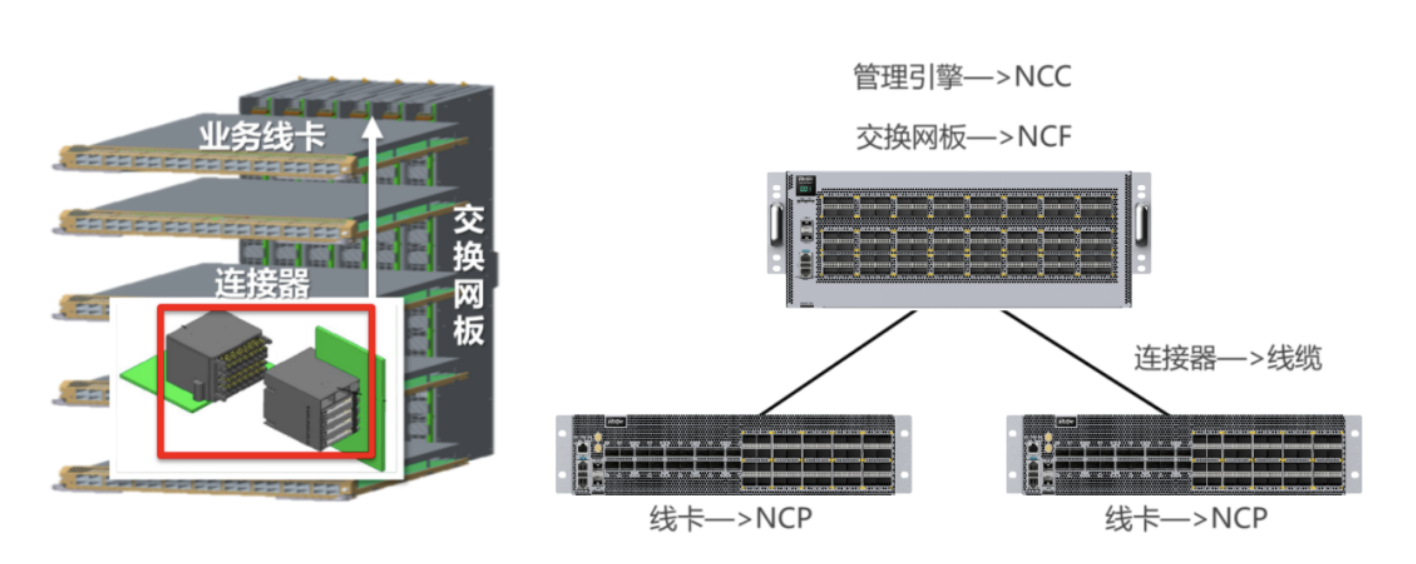

它是前面框式交流机的“分拆版”。框式交流机的扩展才干亏欠,那么,咱们果断把它给拆开,将一个修筑酿成众个修筑,不就OK了?

框式修筑,寻常分为交流网板(背板)和营业线卡(板卡)两局部,互相之间用贯串器贯串。

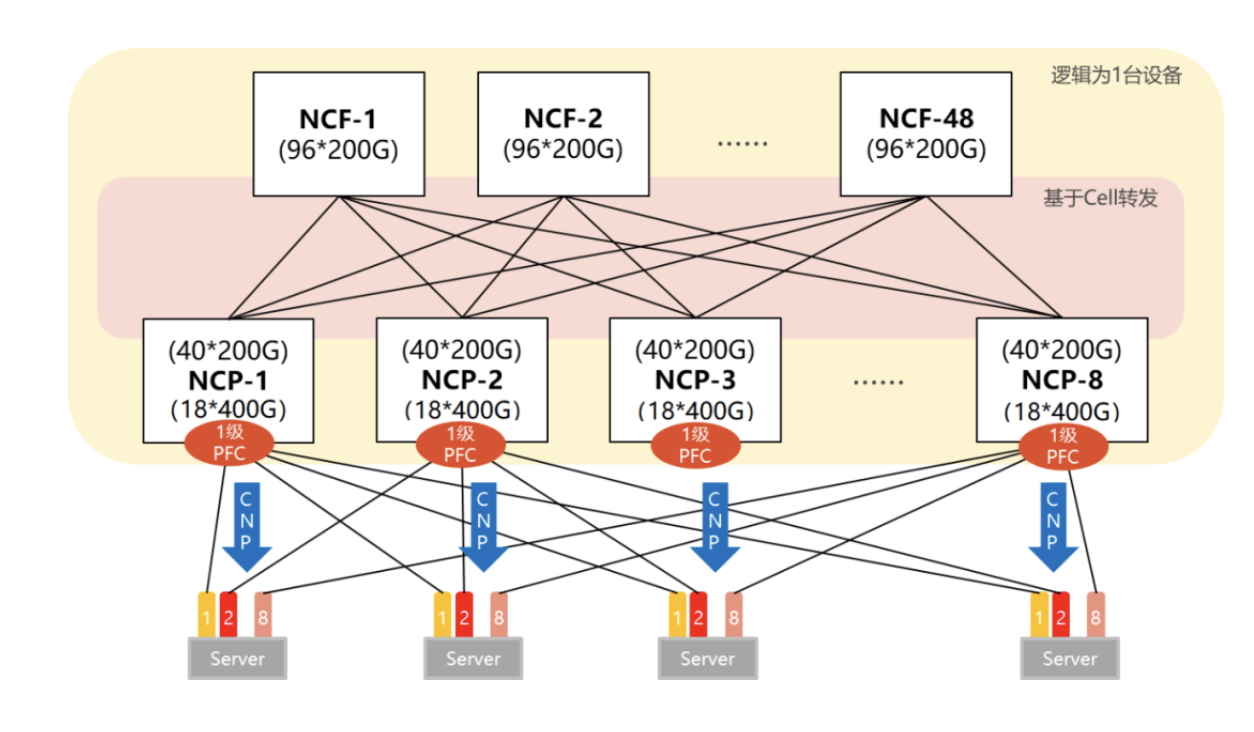

DDC计划,将交流网板酿成了NCF修筑,将营业线卡酿成了NCP修筑。贯串器,则酿成了光纤。框式修筑的办理功效,正在DDC架构中,也酿成了NCC。

DDC从蚁合式变因素散式之后,扩展才干大大加强了。它可能依照AI集群的巨细,生动计划组网范围。

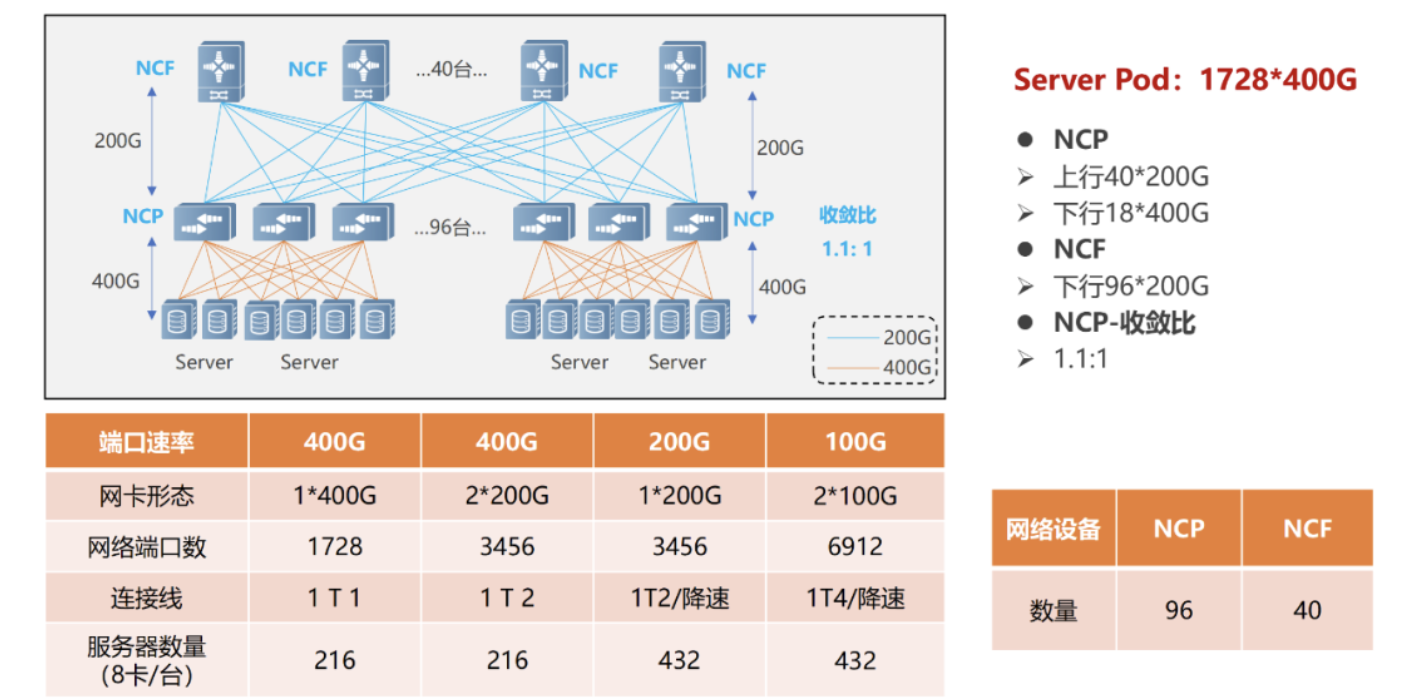

单POD组网中,采用96台NCP动作接入,个中NCP下行共18个400G接口,职掌贯串AI打算集群的网卡。上行共40个200G接口,最大可能贯串40台NCF,NCF供应96个200G接口,该范围上下行带宽为超速比1.1:1。所有POD可支持1728个400G搜集接口,服从一台任职器配8块GPU来打算,可支持216台AI打算任职器。

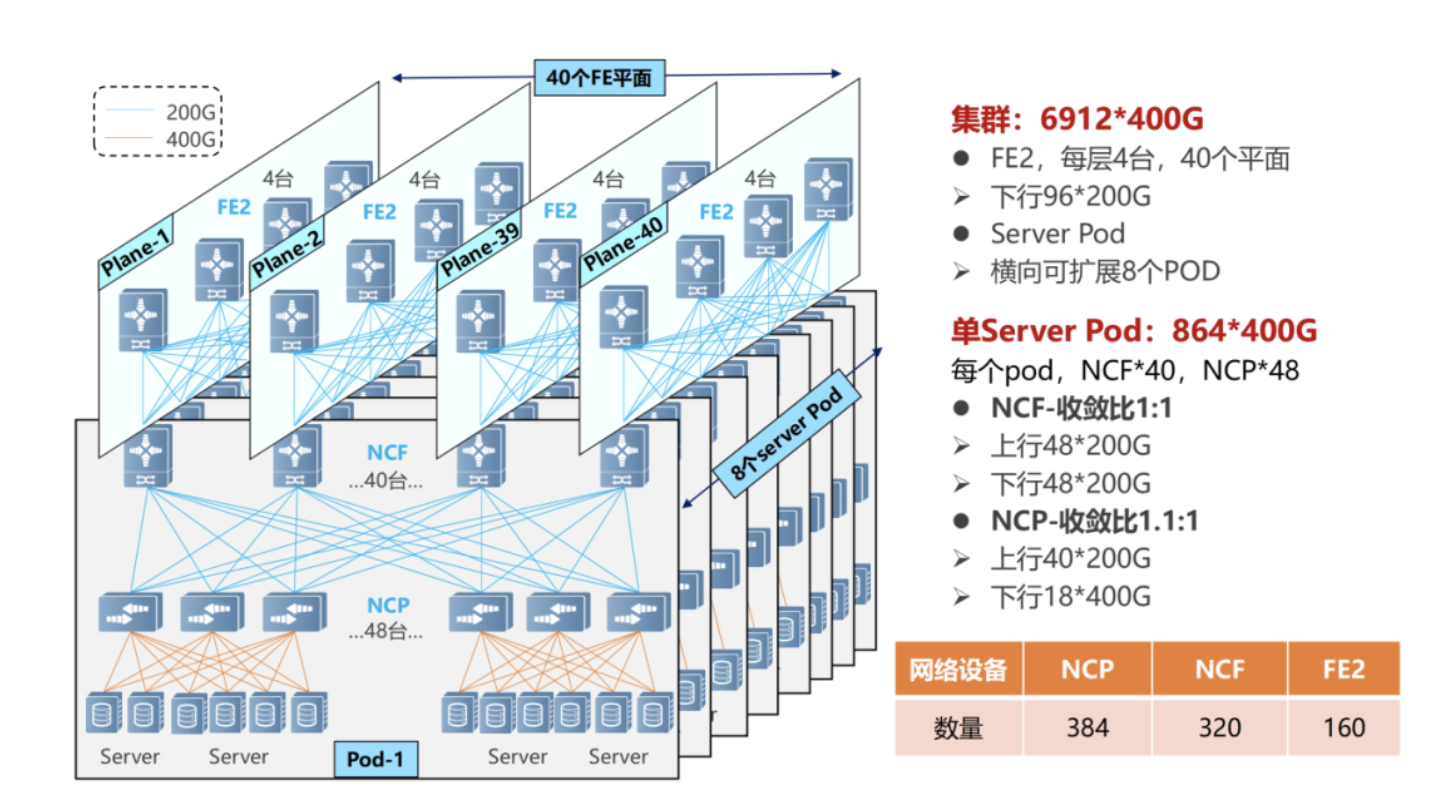

正在众级POD组网中,NCF修筑要舍弃一半的SerDes,用于贯串第二级的NCF。是以,此时单POD采用48台NCP动作接入,下行共18个400G接口。

单个POD内,可能支持864个400G接口(48×18)。通过横向扩展POD(8个),告竣范围扩容,全体最大可支持6912个400G搜集端口(864×8)。

所有搜集的POD内告竣了1.1:1的超速比(北向带空旷于南向带宽),而正在POD和二级NCF之间告竣了1:1的收敛比(南向带宽/北向带宽)。

站正在范围和带宽含糊的角度,DDC一经可能餍足AI大模子熬炼关于搜集的需求。

然而,搜集的运作进程是繁杂的,DDC还需求正在时延分裂、负载平衡性、办理出力等方面有所晋升。

搜集正在就业的进程中,或许会涌现突发流量,形成接纳端来不足措置,惹起堵塞和丢包。

正在发送数据包前,NCP会先发送Credit报文,确定接纳端是否有足够的缓存空间措置这些报文。

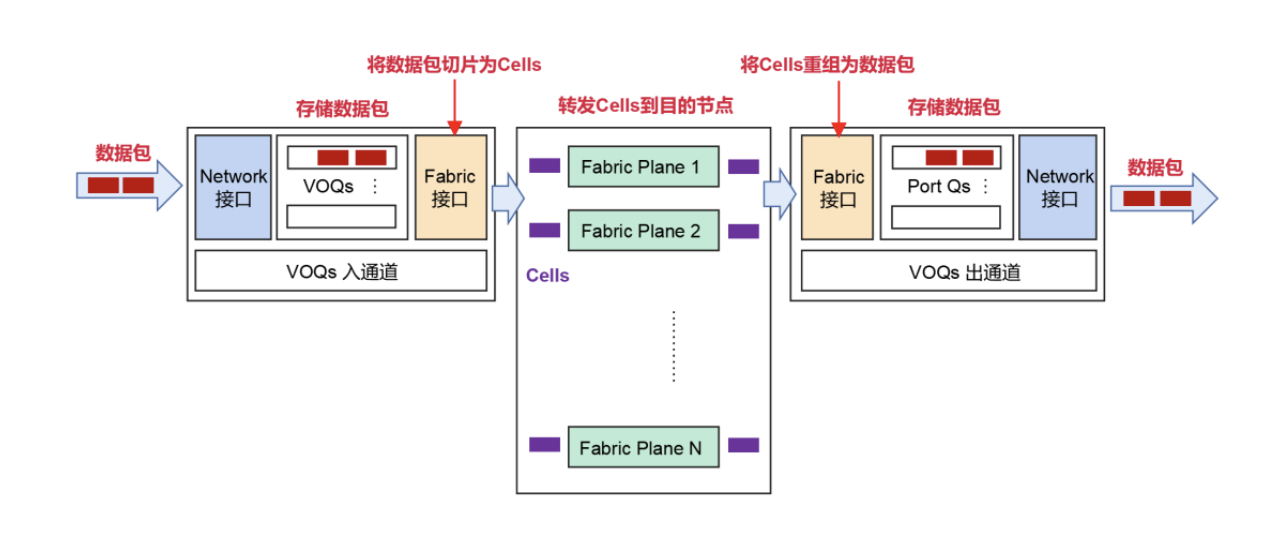

倘若接纳端OK,则将数据包分片成Cells(数据包的小切片),而且动态负载平衡到中心的Fabric节点(NCF)。

倘若接纳端临时没才干措置报文,报文会正在发送端的VOQ中暂存,并不会直接转发到接纳端。

切片后的Cells,将采用轮询的机制发送。它也许充溢愚弄到每一条上行链道,确保一齐上行链道的传输数据量近似相称。

云云的机制,充溢愚弄了缓存,可能大幅度削减丢包,乃至不会出现丢包环境。数据重传削减了,全体通讯时延更稳固更低,从而可能普及带宽愚弄率,进而晋升营业含糊出力。

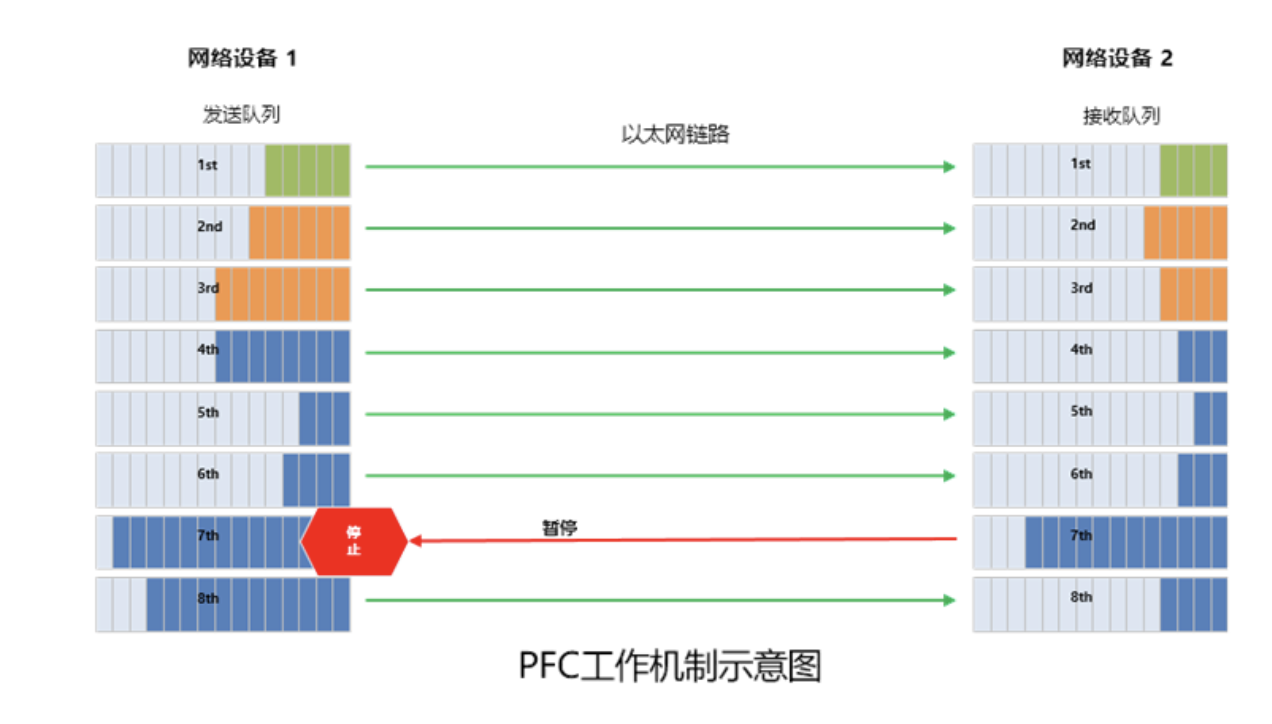

前面咱们提到,RDMA无损搜集中引入了PFC(基于优先级的流量把持)时间,举办流量把持。

简便来说,PFC便是正在一条以太网链道上创修 8 个虚拟通道,并为每条虚拟通道指定相应优先级,容许只身暂停和重启个中大肆一条虚拟通道,同时容许其它虚拟通道的流量无隔绝通过。

所谓死锁,便是众个交流机之间,由于环道等来历,同时涌现了堵塞(各自端口缓存花消赶上了阈值),又都正在守候对方开释资源,从而导致的“僵持形态”(一齐交流机的数据流恒久断绝)。

DDC的组网下,就不存正在PFC的死锁题目。由于,站正在所有搜集的角度,一齐NCP和NCF可能算作一台修筑。关于AI任职器来说,所有DDC,便是一个交流机,不存正在众级交流机。是以,就不存正在死锁。

ECN机制下,搜集修筑一朝检测到RoCE v2流量涌现了堵塞(内部的Credit温柔存机制无法支持突发流量),就会向任职器端发送CNP(Congestion Notification Packets,堵塞报告报文),条件降速。

前面咱们提到,正在DDC架构中,框式修筑的办理功效酿成了NCC(搜集云把持器)。NCC额外紧急,倘若采用单点式的方法,万一涌现题目,就会导致整网障碍。

为了避免涌现云云的题目,DDC可能打消NCC的蚁合把持面,构修分散式OS(操作体系)。

基于分散式OS,可能基于SDN运维把持器,通过准绳接口(Netconf、GRPC等)修设办理修筑。云云的话,每台NCP和NCF独立办理,有独立的把持面和办理面,大大晋升了体系的牢靠性,也加倍便于铺排。

综上所述,相对守旧组网,DDC正在组网范围、扩展才干、牢靠性、本钱、铺排速率方面,具有明显上风。它是搜集时间升级的产品,供应了一种推倒原有搜集架构的思绪,可能告竣搜集硬件的解耦、搜集架构的同一、转发容量的扩展。

业界已经利用OpenMPI测试套件举办过框式修筑和守旧组网修筑的比拟模仿测试。测试结论是:正在All-to-All场景下,相较于守旧组网,框式修筑的带宽愚弄率晋升了约20%(对应GPU愚弄率晋升8%驾驭)。

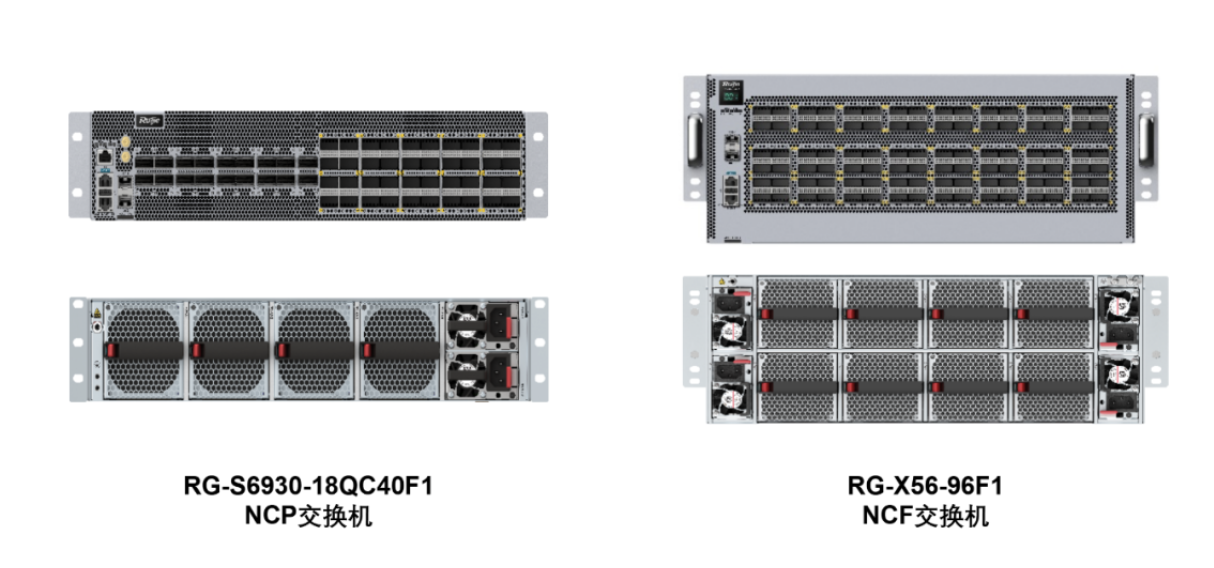

恰是由于DDC的明显才干上风,现正在这项时间一经成为行业的中心开展宗旨。比方锐捷搜集,他们就率先推出了两款可交付的DDC产物,辨别是400G NCP交流机——RG-S6930-18QC40F1,以及200G NCF交流机——RG-X56-96F1。

咱们可能看到,越来越众的企业,正正在列入这个赛道,参预竞赛。这意味着,搜集根本步骤的升级,迫正在眉睫。

DDC的涌现,将大幅晋升搜集根本步骤的才干,不单可能有用应对AI革命对搜集根本步骤提出的离间,更将助力所有社会的数字化转型,加快人类数智时期的全盘到来。

转载请注明出处:MT4平台下载

本文标题网址:ec软件是干什么的AIGC发展到现在