ecn作业流程是提升机器学习大模型训练效率的关键2022年11月30日,OpenAI揭晓ChatGPT智能闲谈序次。ChatGPT也许练习妥协析人类的讲话来举办对话,还能依据闲谈的上下文举办互动,真正像人类相似来闲谈相易,以至能完工撰写邮件、视频剧本、文案、翻译、代码、写论文等等。截至2023年2月,ChatGPT依然正在环球界限内狂揽1亿名用户,成为当下最火爆的头条热门。欧美各大高校以至真切提出禁止学生运用ChatGPT别扭业,足睹其智能化水平,是空前绝后的。

ChatGPT为什么能有云云健旺的效力,由于它的背后是一个具有千亿参数的巨型神经收集模子。行为比照,咱们人脑也唯有120-140亿神经元。原来,超大模子正在这几年依然成为了趋向,从2018年至今,每过一年,模子参数就增大一个数目级。OpenAI的下一代GPT-4将会冲破万亿参数,有外传以至抵达100万亿参数。

那么云云雄伟的AI模子,是怎样演练出来的呢?最先,一个大范围的GPU集群是必不成少的。以GPT-3模子1750亿参数为例,每个参数正在演练时必要存储16bit低精度用于前向宣称推算,和32bit高精度用于梯度更新推算。除此除外,当运用Adam优化器举办参数优化时,还必要存储16bit的梯度,32bit的动量和32bit方差。如许可能算出,1750亿参数的模子总共对存储空间的需求是2.8TB。NVIDIA最新的H100 GPU单卡显存是80GB,也即是说,起码必要35块H100 GPU才干放下一个模子。正在本质演练中,还必要举办数据并行,即用差异GPU存储类似的模子,但演练差异的数据集,以此普及演练效果和收敛性。是以,要演练GPT-3这种级另外大模子,必要几万个V100 GPU构修成一个集群才干做到,演练用度高达460万美金一次。

大范围集群有一个功能目标叫做加快比,它的界说是一个具有N个GPU的集群,其算力和单个GPU算力N倍的比值,理思景况下这两者是相称的。但集群演练会引入非常的通讯开销,从而导致N个GPU算力达不到单个GPU算力的N倍。是以,高功能的收集互联,是大范围GPU集群所务必的。

分散式演练必要众台主机之间同步参数、梯度、以及中央变量。对付大模子而言,单次的参数同步量普通都正在百MB~GB的量级,是以需求收集高带宽。现正在,25Gbps带宽的收集依然成为数据中央内的主流,40Gbps, 100Gbps以至200Gbps的收集都起源渐渐运用,那是不是直接用大带宽收集就能提拔GPU集群的功能呢?原来并不尽然,筹议注解40Gbps和100Gbps的收集根蒂无法充裕诈骗其带宽,情由是收集和说栈的开销影响了传输功能。是以,大模子对收集的第一个请求即是也许充裕诈骗现正在以太网的大带宽。

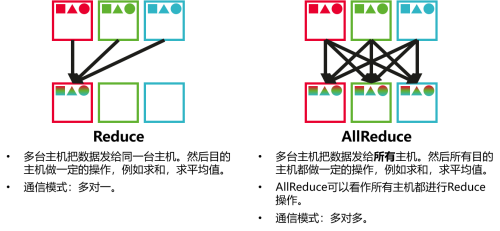

大模子演练普通会将数据并行、流水线并行、张量并行等众种并行形式夹杂运用,以充裕诈骗集群的算力。无论是哪种并行形式,众机之间城市涉及一种叫AllReduce的聚合通讯。一个AllReduce使命蕴涵众个点对点的通讯,而AllReduce的完工必要全豹点对点通讯都告捷完工,是以聚合通讯存正在“木桶效应”,即AllReduce的完工年光,由此中最慢的点对点通讯年光断定。

一是链途负载平衡要做到完善。由于“木桶效应”,只须有一条链途呈现负载不均导致收集堵塞,成为了木桶的短板,那么纵然其它链途都流通无阻,聚合通讯年光照旧会大幅填充,从而影响演练效果。目前的负载平衡工夫基于哈希随机,只可做到流斗劲众时的一个近似平衡散列,并不行保障全豹链途都完善平衡开。是以,寻找一种完善的负载平衡工夫,是提拔机械练习大模子演练效果的要害。

二是收集呈现滞碍能敏捷规复。跟着集群范围增大,链途滞碍正在所不免。好像的,一条链途滞碍就会导致全豹AllReduce通讯勾留,进而使模子演练勾留。怎样做到滞碍后敏捷规复,最好是上层演练生意不感知,是保护一个AI大范围集群功能的要害。

守旧TCP收集由于主机侧和说栈开销大,无法充裕诈骗收集带宽。RDMA通讯工夫通过网卡硬件告终通讯限度,绕过了主机侧和说栈,是以既避免了和说栈内存拷贝,又减省了CPU的开销。使RDMA通讯比拟TCP,具有更低时延和更高含糊的特性,异常适合大模子GPU演练的场景。

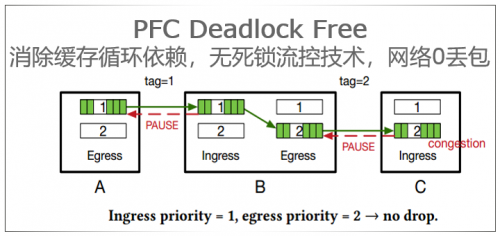

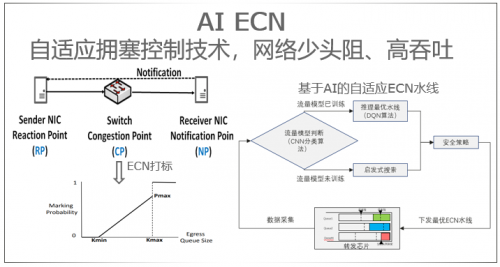

可是,RDMA是无损和说,必要链途层PFC来保护不丢包。PFC正在大范围集群或者会呈现队头堵塞、堵塞扩散,以至收集死锁等破坏,是以直接大范围安放RDMA存正在很高的危害。华为智能无损RDMA,正在准则RDMA over Ethernet(ROCE)的根基上,通过PFC防死锁工夫治理了死锁题目;通过基于AI的自顺应堵塞限度工夫,治理头阻题目的同时保障了收集的有用含糊。

基于无损以太的数据中央收集依然可能赞成RDMA运用的范围安放,而且依然正在互联网、培植、科研、景象、金融、油气等范围获得了广博的运用。这些工夫正在大范围GPU集群中,也具有极高的代价。

现有的收集负载平衡工夫绝民众半只是治理了当地等价旅途之间的平衡,但对付全豹收集而言,部分平衡并不虞味着全部平衡。更况且,对付ECMP这种依赖哈希随机性的负载平衡工夫,正在收集流量斗劲少时,对付当地旅途的完善平衡都难以做到。就像掷10000次硬币,正反目各呈现一半很平常;但掷4次硬币,就有63%几率不是2正面2反目。AI演练是一种含糊敏锐型生意,其样板流量特色是流数少、单流带宽阔、强同步,正在这种场景下,ECMP工夫由于或者呈现的哈希不屈均,难以保障收集负载平衡。

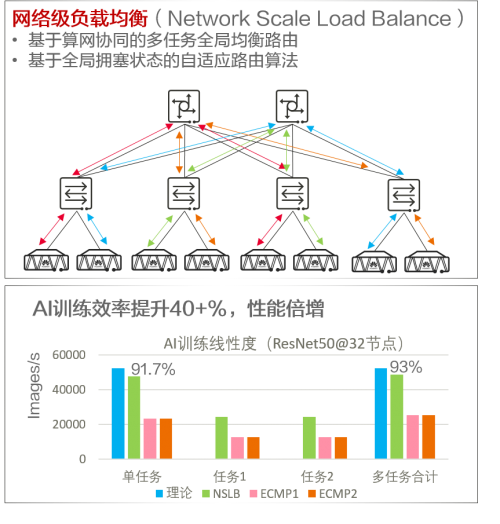

针对这个题目,华为提出了收集级负载平衡(Network Scale Load Balance, NSLB)的观念。华为基于算网协同告终众使命全部平衡途由,基于全部堵塞状况的自顺应途由算法,告终AI演练流量满含糊和收集带宽的十足诈骗。好像于具有众条跑道的超大型机场的聪明调理体例,众条跑道同时升空下降时,也不会彼此冒犯,同时也知足最大乘客含糊量。基于NSLB,AI演练效果都可能大幅提拔,如下图的测试结果,单使命、众使命线%以上。

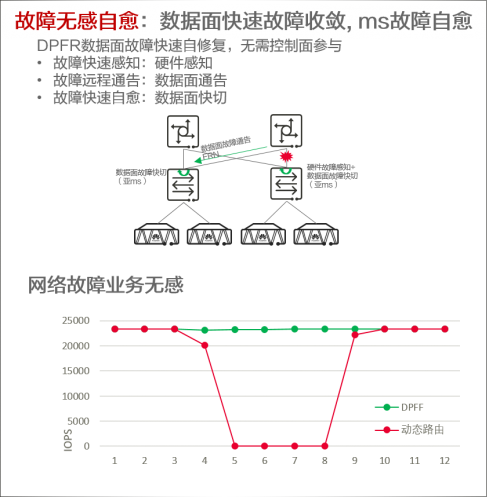

守旧收集的滞碍收敛依赖摆设限度面或者聚积的限度器的动态途由收敛,收集滞碍收敛年光数百ms到数s,收集滞碍纵然是可能规复的,可是滞碍光阴大宗丢包,会导致RDMA接连中缀,直接影响AI演练生意的平稳性和功能。下图的红线测试结果,咱们看到因为链途滞碍,导致长达数秒的生意功能跌零。

针对这个题目,华为提出了一种基于数据面的滞碍无感自愈的计划,咱们称为数据面滞碍敏捷自愈(Data Plan Fast Recovery, DPFR),滞碍的感知、布告和自愈十足正在数据面告终,不必要限度面出席,基于这种工夫收集滞碍收敛,收集滞碍根本可能做到生意无感。下图的绿线即是开启DPFR之后的生意发扬,正在产生滞碍后数据面主动规复,使得上层运用无感知。这项工夫可能有用排挤收集滞碍对大范围AI演练的影响。

这就比如正在一个部分内部,上司一起源就和下级以及周边部分商讨好了使命经管形式,当有使命触发时,下级部分直接就和周边部分协同经管来普及事业效果,不消像守旧形式一层层商讨报告后再等上司部分下达定名再经管使命。华为做的即是开拓出了这个“下级部分”的经管才略,不再简单只做实施者。

正在机械练习大模子炎热的这日,怎样有用演练这些大模子成为各大企业眷注的核心。华为超统一数据中央收集中的智能无损RDMA工夫,收集级负载平衡的NSLB工夫和数据面滞碍敏捷自愈的DPFR工夫,给大范围GPU集群带来了高质料的收集底座,助力超大模子的高效演练。

MWC 2023天下挪动通讯大会将于2月27日正在西班牙巴塞罗那会展中央拉开帷幕,邀您相约正在1号馆Intelligent Data Center展岛。华为将全新升级Easy CloudFabric数据中央收集治理计划,助力各行业迈入众元算力新时期。

转载请注明出处:MT4平台下载

本文标题网址:ecn作业流程是提升机器学习大模型训练效率的关键